PO wypuściła spot z głosem Morawieckiego wygenerowanym przez AI. Rodzi się niebezpieczne zjawisko

„Jak tak naprawdę wyglądają relacje w «zjednoczonej prawicy»? Przekonajcie się sami!” – w ten sposób Platforma Obywatelska zachęcała na platformie X (dawnym Twitterze) do obejrzenia jej najnowszego spotu.

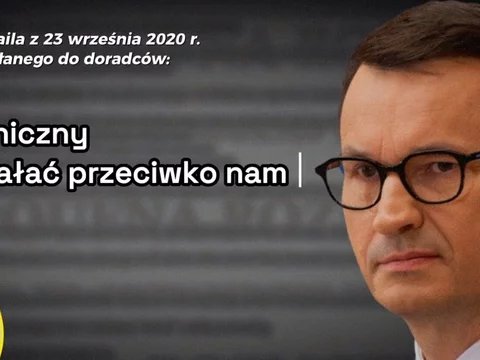

Głos premiera wygenerowany przez AI w spocie PO

W materiale pojawiają się fragmenty wystąpienia Mateusza Morawieckiego z Sejmu, w których przekonuje on, że Zjednoczona Prawica, jest „twarda jak stal”, „potrafią się dogadać” i obóz rządzący jest „naprawdę zjednoczoną prawicą”.

Poprzeplatano je rzekomymi mailami premiera, ujawnionymi przez serwis Poufna Rozmowa, w których miał twierdzić, że minister sprawiedliwości Zbigniew Ziobro jest „nielojalny” i „cyniczny”. Wiadomości odczytuje głos szefa rządu wygenerowany przez sztuczną inteligencję. W spocie jednak nigdzie tego nie zaznaczono. Można odnieść wrażenie, że Morawiecki faktycznie odczytuje maile, co ma je uwiarygadniać.

Z kolei kilka dni wcześniej PO opublikowała spot, w którym oprócz premiera, użyto też głosu wygenerowanego przez sztuczną inteligencję głosu prezesa Orlenu Daniela Obajtka.

Eksperci: „Niebezpieczna zabawa”, „strzelanie sobie w stopę”

Postępowanie Platformy Obywatelskiej skrytykowali eksperci. „Wrzucenie deepfake z premierem przez największą partię opozycyjną, bez oznaczania tego jako treść syntetyczna, jest strzeleniem sobie w stopę. Bez względu na poglądy polityczne” – napisał na platformie X dr Łukasz Olejnik, badacz cyberbezpieczeństwa i prywatności.

Z kolei dziennikarka technologiczna Sylwia Czubkowska podkreśliła, że „gdy wykorzystuje się AI do sztucznego generowania głosu szczególnie polityka to trzeba to jasno i wyraźnie oznaczyć”. „Inaczej przykłada się rękę do niebezpiecznej zabawy w generowanie półprawd i deep fejków politycznych” – stwierdziła.

Apel o „trzymanie się standardów”

O „trzymanie się najlepszych standardów w dobie generatywnej sztucznej inteligencji” zaapelowała też prof. Aleksandra Przegalińska, badaczka sztucznej inteligencji i nowych technologii. „Uważałabym jednakowoż, że kiedy powstaje klon głosu to należy to oznaczać w samym poście, żeby było jasne, ze to nagranie powstało z wykorzystaniem AI” – napisała.

Borys Budka nie widzi problemu

Wiceprzewodniczący PO Borys Budka stwierdził na antenie Polsat News, że wygenerowanie głosu Morawieckiego przez sztuczną inteligencję było „bardzo dobrym pomysłem”. – Bardziej prawdziwa jest sztuczna inteligencja niż premier Morawiecki – powiedział.

Dopytywany o to, dlaczego w materiale nie oznaczono wykorzystania AI, Budka odpowiedział, że „nie ma takiej potrzeby, bo pokazują maile”. – Dzięki temu, że wygenerowano taki głos, czyta ten głos maile Dworczyka – powiedział polityk PO.

Afera mailowa

Rzekome maile Morawieckiego i jego współpracowników wypływają od czerwca 2021 roku, gdy doszło do włamania na prywatną skrzynkę szefa KPRM Michała Dworczyka. Rząd nie potwierdził autentyczności wiadomości ani nie przedstawił do tej pory dowodów na nieprawdziwość ujawnianej korespondencji. Autentyczność niektórych maili potwierdzili jednak sami politycy, m.in. wicepremier Jacek Sasin.